- TOP

- 製品情報

- NVIDIA データ センター GPU

- 製品シリーズ一覧

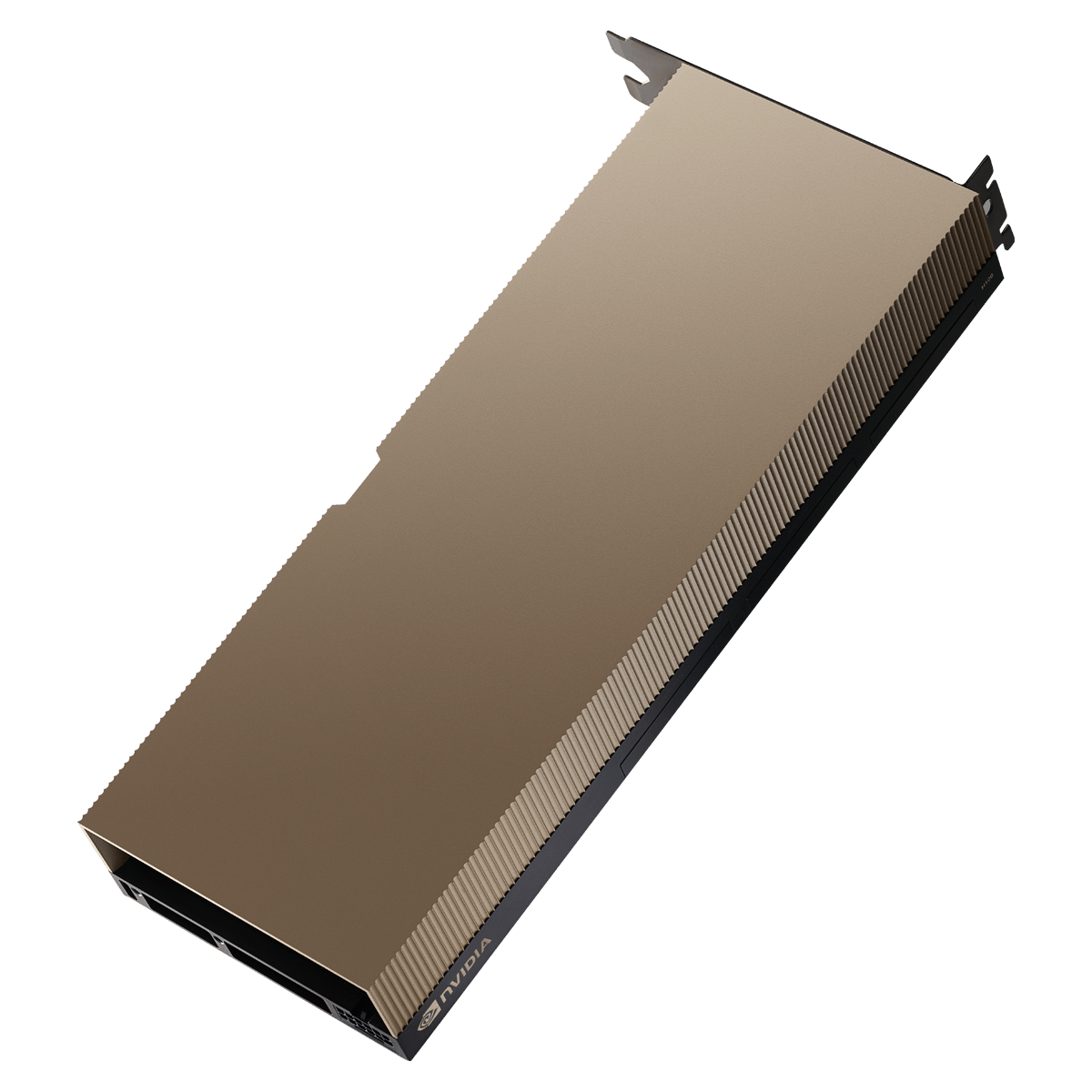

- NVIDIA H100 NVL 94GB

製品情報

NVIDIA H100 NVL 94GB

あらゆるデータ センターにかつてない性能、拡張性、セキュリティを提供。

- 製品概要

製品概要

アクセラレーテッド コンピューティングの大きな飛躍

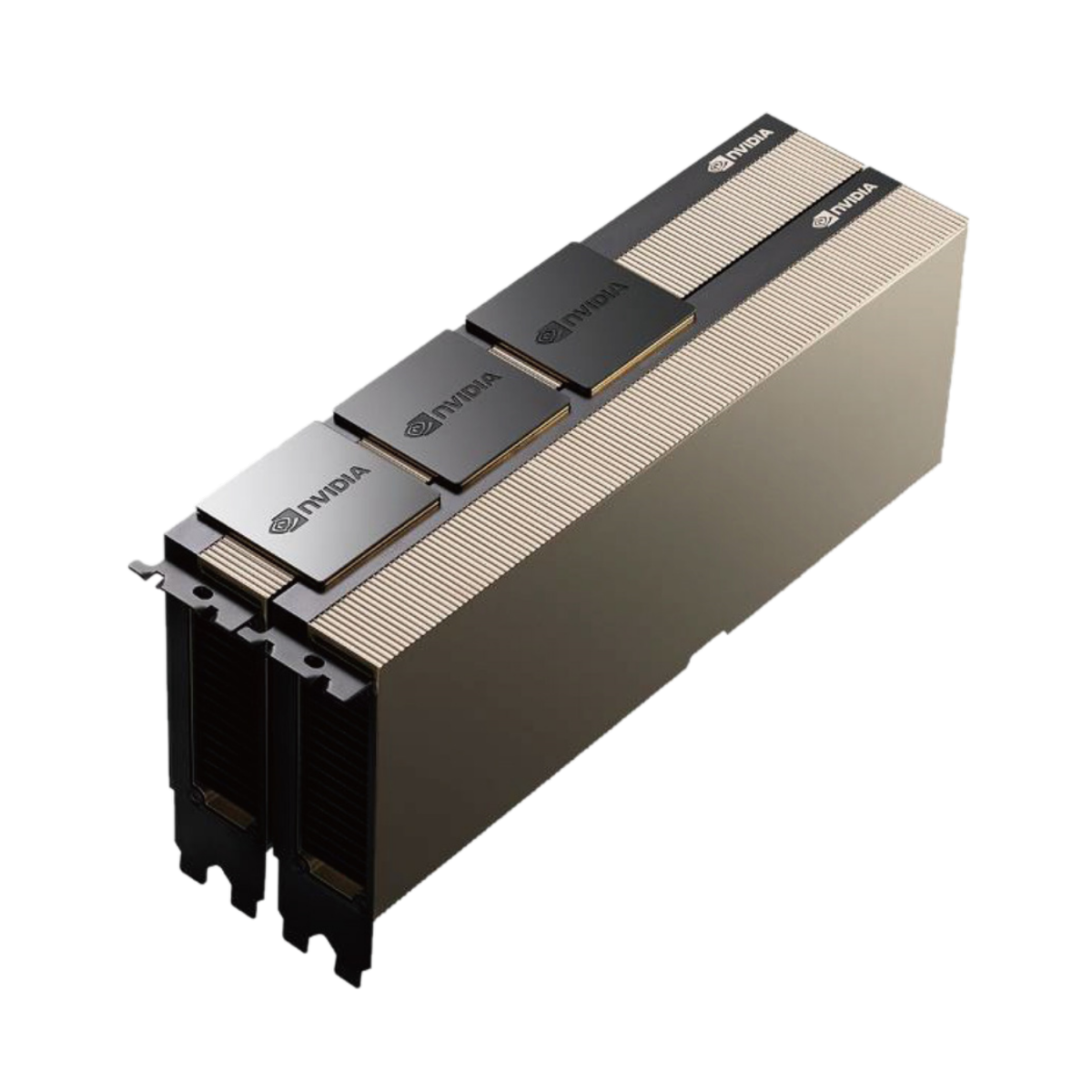

NVIDIA H100 Tensor コア GPUで、あらゆるワークロードのためのかつてない性能、拡張性、セキュリティを手に入れましょう。NVIDIA® NVLink® Switch System により、最大 256 個の H100 を接続し、エクサスケールのワークロードを高速化できます。さらに、専用の Transformer Engine を利用することで、パラメーターが兆単位の言語モデルを実装できます。H100 の複合的な技術革新により、大規模な言語モデルが前世代と比較して 30 倍も高速化され、業界の一歩先を行く対話型 AI が可能となります。

大規模言語モデル推論を加速

最大 1750億 パラメーターの大規模言語モデル (LLM) の場合、PCIe ベースの H100 NVL with NVLink ブリッジ(※)は、Transformer Engine、NVLink、および 188GB HBM3 メモリを利用して、あらゆるデータ センターで最適な性能と容易な拡張性を提供し、LLM を主流にしています。H100 NVL GPU を搭載したサーバーは、電力制約のあるデータ センター環境において低遅延を維持しながら、GPT-175B モデルの性能を NVIDIA DGX™ A100 システムの最大 12 倍まで向上します。※2枚のH100 NVL 94GBを3個のNVLinkブリッジで接続した場合

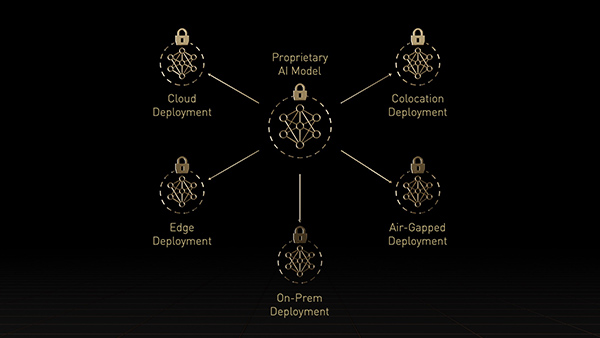

エンタープライズ AI の準備はできていますか?

企業における AI の導入はもはや主流になっており、企業はこの新時代に向けて組織を加速させるエンドツーエンド の AI 対応インフラストラクチャを必要としています。

主流サーバー向けの H100 GPU には、NVIDIA AI Enterprise ソフトウェア スイートのサブスクリプション 5 年分 (エンタープライズ サポートなど) が付属しており、その非常に優れた性能によって AI を簡単に導入できます。それにより、企業や組織は、AI チャットボット、レコメンデーション エンジン、ビジョン AI など、H100 で高速化する AI ワークフローを構築するために必要な AI フレームワークおよびツールが活用できるようになります。

エンタープライズからエクサスケールまでワークロードを安定に高速化

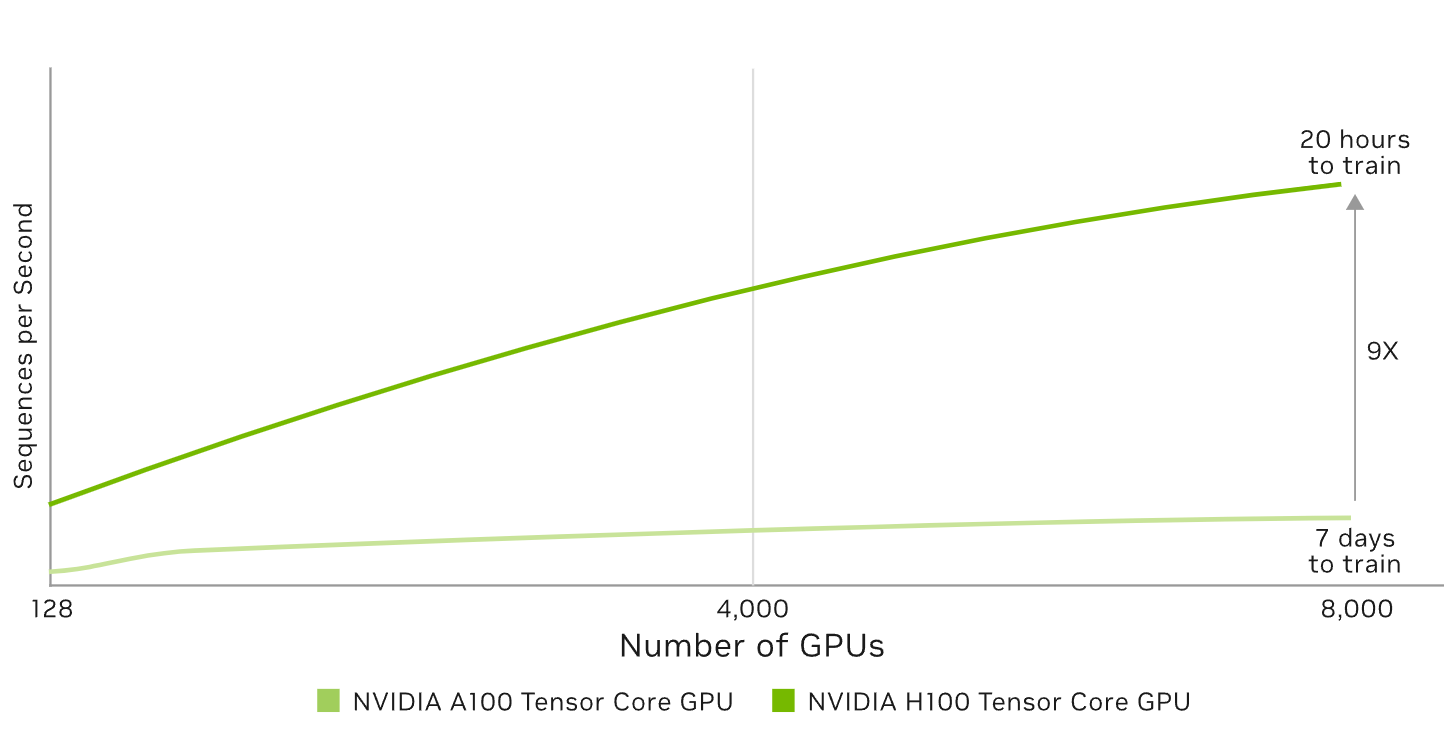

最大規模のモデルでAI トレーニング性能を最大 9 倍に

混合エキスパート (3950 億個のパラメーター)

予想されるパフォーマンスは変更される可能性があります。Training Mixture of Experts (MoE) Transformer Switch-XXL バリアントと 1T トークン データセット上の 395B パラメーター | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLINK スイッチ システム、NDR IB

革新的な AI トレーニング。

H100 は第 4 世代の Tensor コアと、FP8 精度で混合エキスパート (MoE) モデルのトレーニングを前世代比最大 9 倍高速化するTransformer Engine を備えます。GPU と GPU を毎秒 900 ギガバイトで相互接続する第 4 世代 NVLink、ノード全体で GPU ごとに通信を高速化する NVLINK Switch System、PCIe Gen5、NVIDIA Magnum IO™ ソフトウェアの組み合わせによって、小規模なエンタープライズから大規模な統合 GPU クラスターまで効率的なスケーラビリティが与えられます。

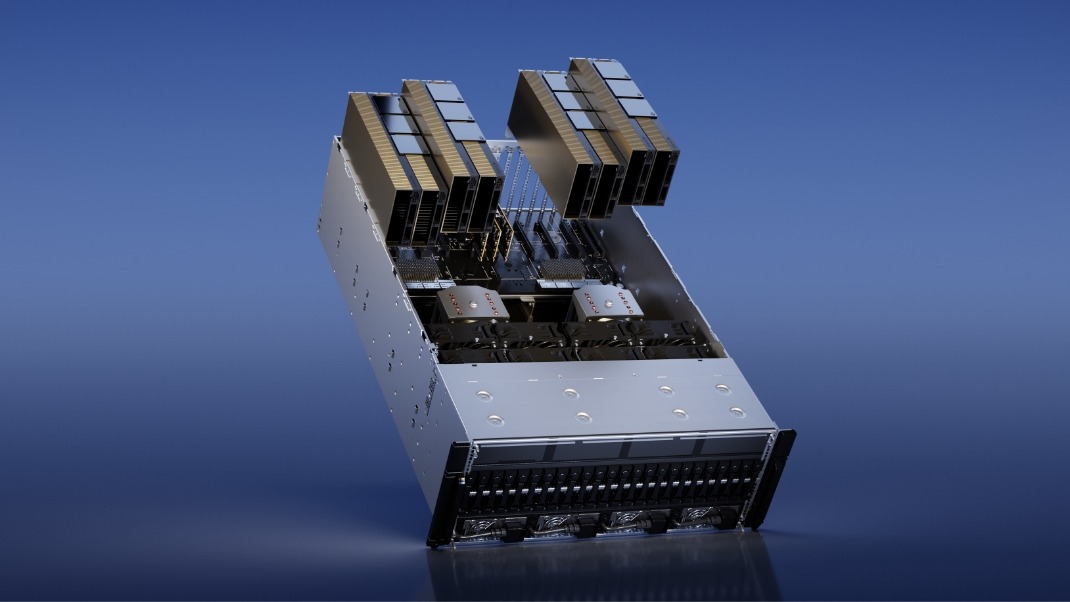

データ センター規模での H100 GPU 導入は卓越したパフォーマンスを実現し、あらゆる研究者に次世代のエクサスケール ハイパフォーマンス コンピューティング (HPC) と兆単位パラメーター AI をもたらします。

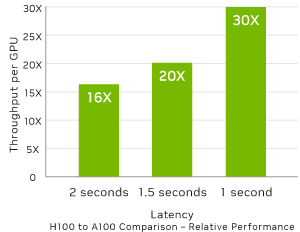

最大規模のモデルで AI 推論性能を最大 30 倍に。

Megatron チャットボット推論 (5300 億個のパラメーター)

Projected performance subject to change. Inference on Megatron 530B parameter model chatbot for input sequence length=128, output sequence length=20 | A100 クラスター:HDR IB ネットワーク | H100 クラスター: 16 個の H100 構成のための NDR IB ネットワーク | 1 秒と 1.5 秒の場合の 32 A100 と 16 H100 の比較 | 2 秒の場合の 16 A100 と 8 H100 の比較

リアルタイムのディープラーニング推論。

AI は、さまざまなビジネスの課題を、同じくらいさまざまなニューラル ネットワークを使用して解決します。優れたAI推論アクセラレータには、最高のパフォーマンスだけでなく、様々なネットワークを加速するための多様性も求められます。

H100 では、推論が最大 30 倍高速化になる、レイテンシが最小限に抑えられるなど、機能が強化されます。それにより、市場をリードする NVIDIAの推論のリーダーシップをさらに拡大します。第 4 世代の Tensor コアは FP64、TF32、FP32、FP16、INT8など、あらゆる精度をスピードアップします。Transformer Engine は FP8 と FP16の両方を活用してメモリ消費を減らしてパフォーマンスを増やしつつ、大規模な言語モデルで精度を維持します。

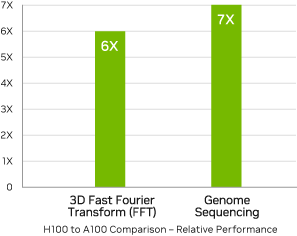

HPC アプリケーションのパフォーマンスが最大 7 倍に。

予想されるパフォーマンスは変更される可能性があります。3D FFT (4K^3) スループット | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLink スイッチ システム、NDR IB | ゲノム シーケンシング (Smith-Waterman) | 1 A100 | 1 H100

エクサスケール ハイパフォーマンス コンピューティング。

NVIDIA データ センター プラットフォームは、ムーアの法則を超えるパフォーマンス向上を継続的に提供します。また、H100 の新しい画期的な AI 機能は、HPC+AIのパワーをさらに増幅し、世界の最重要課題の解決に取り組む科学者や研究者にとって、発見までの時間が加速されます。

H100 は、倍精度 Tensor コアの毎秒浮動小数点演算 (FLOPS) を 2.6 倍にし、HPC で 50 teraFLOPS の FP64 コンピューティングを実現します。AIと融合した HPC アプリケーションでは、H100 の TF32 精度を活用し、コードの変更なしに、単精度行列乗算演算で 700 teraFLOP のスループットを達成することができます。

H100 はまた、DPX 命令を備え、NVIDIA A100 Tensor コア GPU の 7 倍のパフォーマンスを提供し、DNA シーケンス アライメント用の Smith-Watermanなど、動的プログラミング アルゴリズムにおいて従来のデュアルソケット CPU のみのサーバーと比較して 40 倍の高速化を実現します。

データ分析の高速化。

データ分析は多くの場合、AI アプリケーションの開発時間の大半を占めます 大規模なデータセットは複数のサーバーに分散されるため、CPU だけの市販のサーバーによるスケールアウトソリューションでは、スケーラブルなコンピューティング パフォーマンスに欠け、動かなくなります。

H100 で高速化するサーバー、GPU ごとに毎秒 2 テラバイトのメモリ帯域幅、NVLinkによるスケーラビリティなら、膨大なデータセットに対処するハイパフォーマンスとスケールでデータを分析できます。NVIDIA Quantum-2 Infiniband、Magnum IOソフトウェア、GPU 高速化 Spark 3.0、NVIDIA RAPIDS™ と組み合わせることで、NVIDIA データ センタープラットフォームは、比類なきレベルのパフォーマンスと効率性で膨大なワークロードを、他にはない方法で、高速化できます。

企業で効率的に利用。

IT マネージャーはデータ センターでコンピューティング リソースの利用率(ピークと平均の両方)を最大化することを求めます。多くの場合、コンピューティングを動的に再構成し、使用中のワークロードに合わせてリソースを正しいサイズに変更します。

H100 の第 2 世代 マルチ インスタンス GPU (MIG) では、7 個ものインスタンスに分割することで各 GPU の利用率を最大化します。コンフィデンシャル コンピューティング対応のH100では、マルチテナントをエンドツーエンドで安全に利用できます。クラウド サービス プロバイダー (CSP) 環境に最適です。

H100 と MIG なら、インフラストラクチャ管理者は GPU アクセラレーテッドインフラストラクチャを標準化できて、同時に、GPUリソースを非常に細かくプロビジョニングできます。正しい量のアクセラレーテッド コンピューティングが安全に開発者に与えられ、GPUリソースの利用を最適化します。

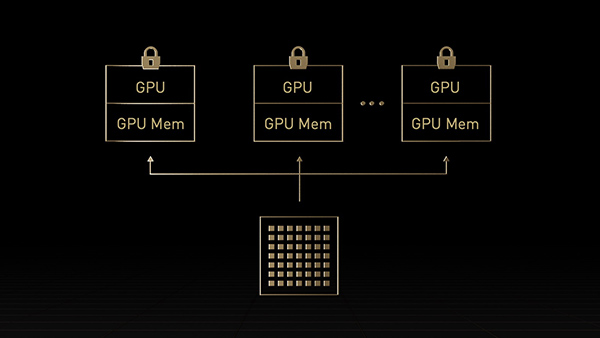

コンフィデンシャル コンピューティングを内蔵。

今日のコンフィデンシャル コンピューティング ソリューションは CPU ベースで、AI や HPC など、大量の計算処理を必要とするワークロードの場合、十分ではありません。NVIDIAコンフィデンシャル コンピューティングは NVIDIA Hopper™ アーキテクチャの組み込みセキュリティ機能です。H100 を、コンフィデンシャルコンピューティング機能のある世界初のアクセラレータにしたのがこのアーキテクチャです。ユーザーは使用中のデータとアプリケーションの機密性と完全性を保護し、同時に、H100 GPUの卓越した高速化を利用できます。ハードウェアベースの TEE (Trusted Execution Environment/信頼できる実行環境) を作り、1 個の H100 GPU で、1個のノード内の複数の H100 GPU で、または個々の MIG インスタンスで実行されるワークロード全体をセキュリティで保護し、隔離します。GPUで高速化するアプリケーションは、何も変更せずに TEE 内で実行できます。また、分割する必要がありません。ユーザーは AI と HPC のための NVIDIAソフトウェアのパワーと、NVIDIA コンフィデンシャル コンピューティングから与えられるハードウェア RoT (Root of Trust/信頼の起点)のセキュリティを組み合わせることができます。

H100 NVL搭載可能サーバー

-

Supermicro SYS-741GE-TNRT

第4世代 インテル Xeon® スケーラブル・プロセッサー

×2基搭載

主要な仕様

- 最大4基のH100 NVL 94GBを搭載可能

- ECC DDR5-4800×16、最大実装4TB(256GB×16)

- PCIe 5.0 x16(FHFL / 2スロット幅)×4

- PCIe 5.0 x16(FHFL / 1スロット幅)×3

- M.2 NVMe×2

- 3.5 "ホットスワップ対応SATA/NVMe/SASドライブベイ×8

(デフォルトでは8台のNVMeドライブをサポート)

- 4基のリムーバブル高耐久性ファン搭載

- 80Plus Titanium規格準拠2000W(1+1)冗長電源

-

Supermicro AS-2015CS-TNR

第4世代AMD EPYC™ 9004シリーズプロセッサ搭載

主要な仕様

- 最大2基のH100 NVL 94GBを搭載可能

- ECC DDR5-4800×12、最大実装3TB(256GB×12)

- PCIe 5.0 x16(FHFL / 2スロット幅)×2

- PCIe 5.0 x16(FHHL / 1スロット幅)×2

- M.2 NVMe×2

- 3.5 "ホットスワップ対応SATA/NVMe/SASドライブベイ×4

- 3.5 "ホットスワップ対応SATA/SASドライブベイ×8

- 3基のリムーバブル高耐久性ファン搭載

- 80Plus Titanium規格準拠1200W(1+1)冗長電源

-

Supermicro SYS-521C-NR

第4世代 インテル Xeon® スケーラブル・プロセッサー

×1基搭載

主要な仕様

- 最大2基のH100 NVL 94GBを搭載可能

- ECC DDR5-4800×16、最大実装4TB(256GB×16)

- PCIe 5.0 x16(FHFL)

2スロット幅×2または1スロット幅×4

- PCIe 5.0 x16(FHHL / 1スロット幅)×2

- M.2 NVMe×2

- 3.5 "ホットスワップ対応SATA/NVMe/SASドライブベイ×12

(うち2台がNVMeハイブリッド)

- 3基のリムーバブル高耐久性80mmファン

- 80Plus Titanium規格準拠1200W(1+1)冗長電源

-

H3 Falcon 5012

搭載デバイスを接続したサーバーへ柔軟に割り当てる

ことが可能なPCI Express 5.0対応拡張ボックス

主要な仕様

- 最大8基のH100 NVL 94GBを搭載可能

- 格納したPCIeデバイスを最大で16台までのホストへ

割り振ることが可能

- PCIe 5.0 x16(FHFL)2スロット幅×12

- 8基のホットスワップ対応デュアルローター80mmファン

- 2700W(2+2または3+1冗長構成)ホットスワップ可能電源